Недавно все передовые СМИ облетела сенсация: Италия запретила развитие искусственного интеллекта и заблокировала чат-бот с ИИ ChatGPT. Затем Германия объявила, что может последовать примеру коллеги по Евросоюзу. Позже выяснилось, что проблема не была связана с работой нейросети как таковой. Александра Орехович, преподаватель образовательной платформы Moscow Digital School, директор по правовым инициативам Фонда развития интернет-инициатив (ФРИИ), объяснила, что блокировка была скорее временным ограничением работы, связанным с обработкой персональных данных:

«Поводом к этим событиям стала утечка переписки пользователей ChatGPT. По итогам расследования регулятор выяснил, что площадка не имеет возможности верифицировать возраст пользователя и не объясняет, как и на каком основании собираются персональные данные для обучения нейросети. Ограничение ввели временное – на 20 дней. В Германии решение о блокировке еще не приняли.

Самым интересным последствием приостановки работы ChatGPT стало то, какой уровень популярности чат-бота блокировка продемонстрировала. По некоторым данным, с момента блокировки нейросети в Италии число скачиваний VPN выросло на 400 %, что говорит о стремлении пользователей не прекращать использование сервиса, даже невзирая на риск неправомерного использования своих данных. При этом число пользователей нейросети по всему миру превысило 100 млн человек.

ChatGPT позволяет делать многое: от написания дипломов и диссертаций до создания приложений и маркетинговых стратегий. И пока эксперты пророчат вымирание огромного количества профессий, с развитием ChatGPT юристам открывается огромное поле для деятельности.

С чем связана такая уверенность? Во-первых, с повышением популярности нейросети возникает вопрос пределов ее применения, так как она способна влиять на умы пользователей. Многие эксперты уже сейчас говорят, что продвинутые нейросети способны формировать мнение путем приоритизации и способа подачи той или иной информации. Более того, исследователи утверждают, что создатели мощных цифровых разумов не в состоянии контролировать их, поэтому не всегда понятно, к чему может привести контакт пользователя с нейросетью. К сожалению, этот тезис уже подтверждается конкретными случаями.

Так, 28 марта в прессе прогремела новость, что в Бельгии отец двоих детей покончил с собой после шести недель общения с ИИ. По словам его жены, семья жила спокойной жизнью, а за полтора месяца до самоубийства муж начал пользоваться нейросетью по имени Eliza, с которой беседовал об изменении климата. В итоге мужчина покончил с собой. Супруга уверена – это связано с использованием ИИ.

Неизвестно, связана ли следующая новость с предыдущей, но факт есть факт: 29 марта Илон Маск, Стив Возняк и больше тысячи экспертов призвали приостановить разработку продвинутого искусственного интеллекта, пока не появятся общие протоколы безопасности. Разумеется, они должны включать в себя пределы, ограничения и требования по разработке и сферам применения ИИ. И также очевидно, что это важнейшая сфера деятельности юристов на ближайшие годы.

Потребность в общих правилах применения объясняется не только безопасностью. Всем известен кейс со студентом, который написал свой диплом с помощью нейросети. В результате вопрос о том, можно ли засчитать работу и выдать студенту документ об окончании вуза, решался на самом высоком уровне. Это показывает, что бесконтрольное применение ChatGPT при обучении может нивелировать сами цели и способы обучения.

Токийский университет решил этот вопрос однозначно – научные работы, написанные с помощью ChatGPT, были запрещены. Те же рекомендации последовали и от университета Киото. В университете Софии студентов будут наказывать, если уличат в пользовании нейросетями при подготовке заданий. А в университете Тохоку предупредили, что излишнее доверие к нейросетям может стать причиной утечки чувствительных или секретных данных.

Более того, министерство образования, культуры, спорта, науки и технологий Японии готовит рекомендации по использованию ChatGPT из-за опасений, что массовое применение чат-бота в сфере образования может помешать воспитанию у учащихся способности мыслить самостоятельно.

Вопросы о применении ChatGPT возникают не только в сфере образования. Так, его популярность заставляет заново осмыслить дилемму «принадлежности» «авторских прав». Может ли человек считаться создателем контента, если он в работе активно применял нейросеть? И в каких пределах ему принадлежат права авторства в таких случаях? Подобные вопросы, связанные с реализацией интеллектуальных прав, придется решать юристам в процессе популяризации применения механизма.

Еще один краеугольный камень развития нейросетей – использование данных: возможности, пределы, основания такого использования. Последний кейс с квазиблокировкой в Италии показывает, что легальное основание требуется не только для сбора персональных данных, но и для их использования при обучении нейросети. И судя по практике, этот момент остается пока довольно тонким для разработчиков ChatGPT и подобных нейросетей.

Несмотря на огромное количество вопросов ко многим аспектам использования нейросети, некоторые компаний рассматривают ее внедрение в свои сервисы на постоянной основе. К примеру, основатель «Википедии» Джимми Уэйлс сообщал, что планирует использовать нейросеть ChatGPT для написания статей энциклопедии. Инновация, по его подсчетам, обойдется всего в 1,3 тыс. долларов за год.

На первый взгляд, идея хорошая: кто, как не нейросеть, специализирующаяся на создании текстов, подходит для этой роли? Однако в процессе использования ChatGPT выяснилось очень много особенностей, которые делают ее применение в этих целях как минимум спорным. К примеру, сервис генерирует несуществующие ссылки и крайне правдоподобные цитаты, которые произнесены не были. А обучается модель на основе текстов в интернете, далеко не все из которых достоверны и могут считаться надежными источниками. Но даже с учетом таких моментов написанный с помощью ChatGPT материал прошел процедуру рецензирования, чем вызвал шок в научном сообществе. Возникает вопрос: кто понесет ответственность, если нейросеть может сгенерировать недостоверную информацию? Разрешение подобных ситуаций с правовой точки зрения также может стать работой юристов на ближайшие годы.

Для тех коллег, которые наслышаны о вымирании профессии юриста в связи с развитием нейросетей, есть утешительная история: компания DONotPAy, создавшая робота-юриста для консультаций в режиме реального времени на судебном процессе, отказалась от своей идеи после множества предупреждений от адвокатских палат. Юристы отметили, что подобные эксперименты над людьми с явно ненадежным ботом грозят штрафами и заключением вплоть до 6 месяцев.

Видимо, пока судиться придется настоящим, живым юристам. Впрочем, им не возбраняется применять ИИ в своей работе, если, конечно, юрист готов нести такую ответственность».

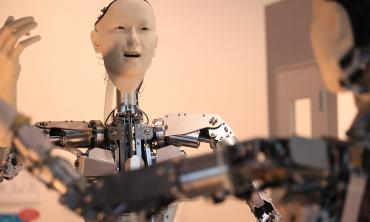

Фото: РИА Новости/Анна Раткогло